esxi6.7 与 pve6 unixbench跑分对比

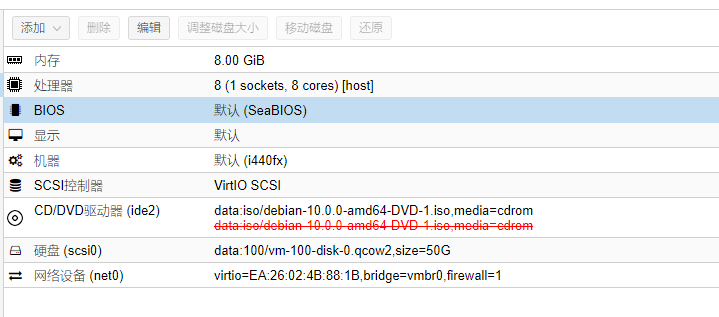

新建的虚拟机下同配置跑的分,均开启了host。配置为 8C8G50G。

ESXI6.7

# # # # # # # ##### ###### # # #### # #

# # ## # # # # # # # ## # # # # #

# # # # # # ## ##### ##### # # # # ######

# # # # # # ## # # # # # # # # #

# # # ## # # # # # # # ## # # # #

#### # # # # # ##### ###### # # #### # #

Version 5.1.3 Based on the Byte Magazine Unix Benchmark

Multi-CPU version Version 5 revisions by Ian Smith,

Sunnyvale, CA, USA

January 13, 2011 johantheghost at yahoo period com

Wide character in print at ./Run line 1511.

Wide character in printf at ./Run line 1542.

1 x Dhrystone 2 using register variables 1 2 3 4 5 6 7 8 9 10

1 x Double-Precision Whetstone 1 2 3 4 5 6 7 8 9 10

1 x Execl Throughput 1 2 3

1 x File Copy 1024 bufsize 2000 maxblocks 1 2 3

1 x File Copy 256 bufsize 500 maxblocks 1 2 3

1 x File Copy 4096 bufsize 8000 maxblocks 1 2 3

1 x Pipe Throughput 1 2 3 4 5 6 7 8 9 10

1 x Pipe-based Context Switching 1 2 3 4 5 6 7 8 9 10

1 x Process Creation 1 2 3

1 x System Call Overhead 1 2 3 4 5 6 7 8 9 10

1 x Shell Scripts (1 concurrent) 1 2 3

1 x Shell Scripts (8 concurrent) 1 2 3

Wide character in printf at ./Run line 1484.

8 x Dhrystone 2 using register variables 1 2 3 4 5 6 7 8 9 10

8 x Double-Precision Whetstone 1 2 3 4 5 6 7 8 9 10

8 x Execl Throughput 1 2 3

8 x File Copy 1024 bufsize 2000 maxblocks 1 2 3

8 x File Copy 256 bufsize 500 maxblocks 1 2 3

8 x File Copy 4096 bufsize 8000 maxblocks 1 2 3

8 x Pipe Throughput 1 2 3 4 5 6 7 8 9 10

8 x Pipe-based Context Switching 1 2 3 4 5 6 7 8 9 10

8 x Process Creation 1 2 3

8 x System Call Overhead 1 2 3 4 5 6 7 8 9 10

8 x Shell Scripts (1 concurrent) 1 2 3

8 x Shell Scripts (8 concurrent) 1 2 3

Wide character in printf at ./Run line 1484.

========================================================================

BYTE UNIX Benchmarks (Version 5.1.3)

System: debian: GNU/Linux

OS: GNU/Linux -- 4.19.0-5-amd64 -- #1 SMP Debian 4.19.37-5 (2019-06-19)

Machine: x86_64 (unknown)

Language: en_US.utf8 (charmap="ANSI_X3.4-1968", collate="ANSI_X3.4-1968")

CPU 0: Intel(R) Xeon(R) CPU E5-2696 v2 @ 2.50GHz (5000.0 bogomips)

Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET, Intel virtualization

CPU 1: Intel(R) Xeon(R) CPU E5-2696 v2 @ 2.50GHz (5000.0 bogomips)

Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET, Intel virtualization

CPU 2: Intel(R) Xeon(R) CPU E5-2696 v2 @ 2.50GHz (5000.0 bogomips)

Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET, Intel virtualization

CPU 3: Intel(R) Xeon(R) CPU E5-2696 v2 @ 2.50GHz (5000.0 bogomips)

Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET, Intel virtualization

CPU 4: Intel(R) Xeon(R) CPU E5-2696 v2 @ 2.50GHz (5000.0 bogomips)

Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET, Intel virtualization

CPU 5: Intel(R) Xeon(R) CPU E5-2696 v2 @ 2.50GHz (5000.0 bogomips)

Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET, Intel virtualization

CPU 6: Intel(R) Xeon(R) CPU E5-2696 v2 @ 2.50GHz (5000.0 bogomips)

Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET, Intel virtualization

CPU 7: Intel(R) Xeon(R) CPU E5-2696 v2 @ 2.50GHz (5000.0 bogomips)

Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET, Intel virtualization

01:35:22 up 1:33, 2 users, load average: 3.18, 3.77, 2.12; runlevel

------------------------------------------------------------------------

Benchmark Run: 一 8月 10 2020 01:35:22 - 02:02:31

8 CPUs in system; running 1 parallel copy of tests

Dhrystone 2 using register variables 37275700.7 lps (10.0 s, 7 samples)

Double-Precision Whetstone 5654.1 MWIPS (6.2 s, 7 samples)

Execl Throughput 4156.3 lps (30.0 s, 2 samples)

File Copy 1024 bufsize 2000 maxblocks 697111.7 KBps (30.0 s, 2 samples)

File Copy 256 bufsize 500 maxblocks 187842.5 KBps (30.0 s, 2 samples)

File Copy 4096 bufsize 8000 maxblocks 2194571.2 KBps (30.0 s, 2 samples)

Pipe Throughput 985672.0 lps (10.0 s, 7 samples)

Pipe-based Context Switching 46277.6 lps (10.0 s, 7 samples)

Process Creation 2855.4 lps (30.0 s, 2 samples)

Shell Scripts (1 concurrent) 4167.8 lpm (60.0 s, 2 samples)

Shell Scripts (8 concurrent) 1955.7 lpm (60.0 s, 2 samples)

System Call Overhead 688554.4 lps (10.0 s, 7 samples)

System Benchmarks Index Values BASELINE RESULT INDEX

Dhrystone 2 using register variables 116700.0 37275700.7 3194.1

Double-Precision Whetstone 55.0 5654.1 1028.0

Execl Throughput 43.0 4156.3 966.6

File Copy 1024 bufsize 2000 maxblocks 3960.0 697111.7 1760.4

File Copy 256 bufsize 500 maxblocks 1655.0 187842.5 1135.0

File Copy 4096 bufsize 8000 maxblocks 5800.0 2194571.2 3783.7

Pipe Throughput 12440.0 985672.0 792.3

Pipe-based Context Switching 4000.0 46277.6 115.7

Process Creation 126.0 2855.4 226.6

Shell Scripts (1 concurrent) 42.4 4167.8 983.0

Shell Scripts (8 concurrent) 6.0 1955.7 3259.4

System Call Overhead 15000.0 688554.4 459.0

========

System Benchmarks Index Score 974.5

------------------------------------------------------------------------

Benchmark Run: 一 8月 10 2020 02:02:31 - 02:29:45

8 CPUs in system; running 8 parallel copies of tests

Dhrystone 2 using register variables 272463301.5 lps (10.0 s, 7 samples)

Double-Precision Whetstone 41703.8 MWIPS (6.5 s, 7 samples)

Execl Throughput 23978.3 lps (30.0 s, 2 samples)

File Copy 1024 bufsize 2000 maxblocks 979782.2 KBps (30.0 s, 2 samples)

File Copy 256 bufsize 500 maxblocks 263271.7 KBps (30.0 s, 2 samples)

File Copy 4096 bufsize 8000 maxblocks 3177481.5 KBps (30.0 s, 2 samples)

Pipe Throughput 7084002.7 lps (10.0 s, 7 samples)

Pipe-based Context Switching 1632492.5 lps (10.0 s, 7 samples)

Process Creation 43134.3 lps (30.0 s, 2 samples)

Shell Scripts (1 concurrent) 44920.5 lpm (60.0 s, 2 samples)

Shell Scripts (8 concurrent) 6769.3 lpm (60.0 s, 2 samples)

System Call Overhead 4393974.7 lps (10.0 s, 7 samples)

System Benchmarks Index Values BASELINE RESULT INDEX

Dhrystone 2 using register variables 116700.0 272463301.5 23347.3

Double-Precision Whetstone 55.0 41703.8 7582.5

Execl Throughput 43.0 23978.3 5576.3

File Copy 1024 bufsize 2000 maxblocks 3960.0 979782.2 2474.2

File Copy 256 bufsize 500 maxblocks 1655.0 263271.7 1590.8

File Copy 4096 bufsize 8000 maxblocks 5800.0 3177481.5 5478.4

Pipe Throughput 12440.0 7084002.7 5694.5

Pipe-based Context Switching 4000.0 1632492.5 4081.2

Process Creation 126.0 43134.3 3423.4

Shell Scripts (1 concurrent) 42.4 44920.5 10594.5

Shell Scripts (8 concurrent) 6.0 6769.3 11282.1

System Call Overhead 15000.0 4393974.7 2929.3

========

System Benchmarks Index Score 5383.8

======= Script description and score comparison completed! =======PVE6.2

make[1]: Leaving directory '/opt/unixbench/UnixBench'

locale: Cannot set LC_CTYPE to default locale: No such file or directory

locale: Cannot set LC_MESSAGES to default locale: No such file or directory

locale: Cannot set LC_ALL to default locale: No such file or directory

locale: Cannot set LC_CTYPE to default locale: No such file or directory

locale: Cannot set LC_MESSAGES to default locale: No such file or directory

locale: Cannot set LC_ALL to default locale: No such file or directory

sh: 1: 3dinfo: not found

sh: 1: runlevel: not found

# # # # # # # ##### ###### # # #### # #

# # ## # # # # # # # ## # # # # #

# # # # # # ## ##### ##### # # # # ######

# # # # # # ## # # # # # # # # #

# # # ## # # # # # # # ## # # # #

#### # # # # # ##### ###### # # #### # #

Version 5.1.3 Based on the Byte Magazine Unix Benchmark

Multi-CPU version Version 5 revisions by Ian Smith,

Sunnyvale, CA, USA

January 13, 2011 johantheghost at yahoo period com

Wide character in print at ./Run line 1511.

Wide character in printf at ./Run line 1542.

1 x Dhrystone 2 using register variables 1 2 3 4 5 6 7 8 9 10

1 x Double-Precision Whetstone 1 2 3 4 5 6 7 8 9 10

1 x Execl Throughput 1 2 3

1 x File Copy 1024 bufsize 2000 maxblocks 1 2 3

1 x File Copy 256 bufsize 500 maxblocks 1 2 3

1 x File Copy 4096 bufsize 8000 maxblocks 1 2 3

1 x Pipe Throughput 1 2 3 4 5 6 7 8 9 10

1 x Pipe-based Context Switching 1 2 3 4 5 6 7 8 9 10

1 x Process Creation 1 2 3

1 x System Call Overhead 1 2 3 4 5 6 7 8 9 10

1 x Shell Scripts (1 concurrent) 1 2 3

1 x Shell Scripts (8 concurrent) 1 2 3

Wide character in printf at ./Run line 1484.

8 x Dhrystone 2 using register variables 1 2 3 4 5 6 7 8 9 10

8 x Double-Precision Whetstone 1 2 3 4 5 6 7 8 9 10

8 x Execl Throughput 1 2 3

8 x File Copy 1024 bufsize 2000 maxblocks 1 2 3

8 x File Copy 256 bufsize 500 maxblocks 1 2 3

8 x File Copy 4096 bufsize 8000 maxblocks 1 2 3

8 x Pipe Throughput 1 2 3 4 5 6 7 8 9 10

8 x Pipe-based Context Switching 1 2 3 4 5 6 7 8 9 10

8 x Process Creation 1 2 3

8 x System Call Overhead 1 2 3 4 5 6 7 8 9 10

8 x Shell Scripts (1 concurrent) 1 2 3

8 x Shell Scripts (8 concurrent) 1 2 3

Wide character in printf at ./Run line 1484.

========================================================================

BYTE UNIX Benchmarks (Version 5.1.3)

System: debian: GNU/Linux

OS: GNU/Linux -- 4.19.0-5-amd64 -- #1 SMP Debian 4.19.37-5 (2019-06-19)

Machine: x86_64 (unknown)

Language: en_US.utf8 (charmap="ANSI_X3.4-1968", collate="ANSI_X3.4-1968")

CPU 0: Intel(R) Xeon(R) CPU E5-2696 v2 @ 2.50GHz (5000.0 bogomips)

Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET

CPU 1: Intel(R) Xeon(R) CPU E5-2696 v2 @ 2.50GHz (5000.0 bogomips)

Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET

CPU 2: Intel(R) Xeon(R) CPU E5-2696 v2 @ 2.50GHz (5000.0 bogomips)

Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET

CPU 3: Intel(R) Xeon(R) CPU E5-2696 v2 @ 2.50GHz (5000.0 bogomips)

Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET

CPU 4: Intel(R) Xeon(R) CPU E5-2696 v2 @ 2.50GHz (5000.0 bogomips)

Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET

CPU 5: Intel(R) Xeon(R) CPU E5-2696 v2 @ 2.50GHz (5000.0 bogomips)

Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET

CPU 6: Intel(R) Xeon(R) CPU E5-2696 v2 @ 2.50GHz (5000.0 bogomips)

Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET

CPU 7: Intel(R) Xeon(R) CPU E5-2696 v2 @ 2.50GHz (5000.0 bogomips)

Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET

11:14:36 up 3 min, 2 users, load average: 0.57, 0.19, 0.06; runlevel

------------------------------------------------------------------------

Benchmark Run: 二 8月 11 2020 11:14:36 - 11:42:00

8 CPUs in system; running 1 parallel copy of tests

Dhrystone 2 using register variables 38457773.2 lps (10.0 s, 7 samples)

Double-Precision Whetstone 5894.1 MWIPS (7.7 s, 7 samples)

Execl Throughput 3653.5 lps (30.0 s, 2 samples)

File Copy 1024 bufsize 2000 maxblocks 594688.8 KBps (30.0 s, 2 samples)

File Copy 256 bufsize 500 maxblocks 155116.1 KBps (30.0 s, 2 samples)

File Copy 4096 bufsize 8000 maxblocks 2093652.8 KBps (30.0 s, 2 samples)

Pipe Throughput 840578.6 lps (10.0 s, 7 samples)

Pipe-based Context Switching 69113.8 lps (10.0 s, 7 samples)

Process Creation 2092.7 lps (30.0 s, 2 samples)

Shell Scripts (1 concurrent) 3592.3 lpm (60.0 s, 2 samples)

Shell Scripts (8 concurrent) 1596.2 lpm (60.0 s, 2 samples)

System Call Overhead 661908.8 lps (10.0 s, 7 samples)

System Benchmarks Index Values BASELINE RESULT INDEX

Dhrystone 2 using register variables 116700.0 38457773.2 3295.4

Double-Precision Whetstone 55.0 5894.1 1071.7

Execl Throughput 43.0 3653.5 849.6

File Copy 1024 bufsize 2000 maxblocks 3960.0 594688.8 1501.7

File Copy 256 bufsize 500 maxblocks 1655.0 155116.1 937.3

File Copy 4096 bufsize 8000 maxblocks 5800.0 2093652.8 3609.7

Pipe Throughput 12440.0 840578.6 675.7

Pipe-based Context Switching 4000.0 69113.8 172.8

Process Creation 126.0 2092.7 166.1

Shell Scripts (1 concurrent) 42.4 3592.3 847.2

Shell Scripts (8 concurrent) 6.0 1596.2 2660.3

System Call Overhead 15000.0 661908.8 441.3

========

System Benchmarks Index Score 903.0

------------------------------------------------------------------------

Benchmark Run: 二 8月 11 2020 11:42:00 - 12:09:16

8 CPUs in system; running 8 parallel copies of tests

Dhrystone 2 using register variables 279669766.0 lps (10.0 s, 7 samples)

Double-Precision Whetstone 41943.0 MWIPS (6.3 s, 7 samples)

Execl Throughput 18412.5 lps (30.0 s, 2 samples)

File Copy 1024 bufsize 2000 maxblocks 488871.1 KBps (30.0 s, 2 samples)

File Copy 256 bufsize 500 maxblocks 126347.3 KBps (30.0 s, 2 samples)

File Copy 4096 bufsize 8000 maxblocks 1596495.9 KBps (30.0 s, 2 samples)

Pipe Throughput 6013413.0 lps (10.0 s, 7 samples)

Pipe-based Context Switching 967469.4 lps (10.0 s, 7 samples)

Process Creation 25260.2 lps (30.0 s, 2 samples)

Shell Scripts (1 concurrent) 37695.0 lpm (60.0 s, 2 samples)

Shell Scripts (8 concurrent) 5645.7 lpm (60.0 s, 2 samples)

System Call Overhead 3703628.1 lps (10.0 s, 7 samples)

System Benchmarks Index Values BASELINE RESULT INDEX

Dhrystone 2 using register variables 116700.0 279669766.0 23964.8

Double-Precision Whetstone 55.0 41943.0 7626.0

Execl Throughput 43.0 18412.5 4282.0

File Copy 1024 bufsize 2000 maxblocks 3960.0 488871.1 1234.5

File Copy 256 bufsize 500 maxblocks 1655.0 126347.3 763.4

File Copy 4096 bufsize 8000 maxblocks 5800.0 1596495.9 2752.6

Pipe Throughput 12440.0 6013413.0 4833.9

Pipe-based Context Switching 4000.0 967469.4 2418.7

Process Creation 126.0 25260.2 2004.8

Shell Scripts (1 concurrent) 42.4 37695.0 8890.3

Shell Scripts (8 concurrent) 6.0 5645.7 9409.4

System Call Overhead 15000.0 3703628.1 2469.1

========

System Benchmarks Index Score 3825.7

======= Script description and score comparison completed! =======